Le débat sur le diagnostic par intelligence artificielle refait surface à l’occasion du congrès de médecine générale en Nouvelle Zélande. La twittosphère médicale britannique était particulièrement critique envers la présentation de Babylon Health, la plateforme en ligne d’anamnèse intelligente avec proposition de diagnostic différentiel très populaire sur smartphone. Lors de la présentation, le représentant de Babylon a vanté les prouesses de l’IA de sa compagnie qui aurait performé mieux à l’examen final de médecine générale (du Collège Royal de Médecine Générale britannique MRCGP) que les médecins en fin de formation. Les propos sont très mal passés au sein des médecins tant spécialistes que généralistes anglais, qui ont fortement critiqué les affirmations de la compagnie.

I’m surprised Babylon continues to say they outperformed GP trainees in an exam when the evidence for the claim has been publicly dismantled https://t.co/NwJwiYTMo1 https://t.co/Bnuq981RjH

— Enrico Coiera (@EnricoCoiera) July 27, 2019

Dans un cadre plus général, le diagnostic machine non supervisé a été critiqué également dans The Lancet, dans une correspondance où les auteurs plaidaient pour la mise en place de guidelines de revision indépendante dans applications voulant poser un diagnostic sans l’avis d’un médecin.

Mon chatbot m’a tué

Un médecin spécialiste anglais, le Dr. Murphy, s’est prêté au jeu et a partagé son propre test de l’application Babylon, avec un cas “textbook”, celui de la suspicion de l’embolie pulmonaire chez un patient à risque. Le patient proposé était un fumeur de 66 ans se plaignant de hémoptysie, douleur latérothoracique respiro-dépendante, dyspnée et un mollet gonflé.

A 66yr old male smoker recently returned from Holiday. Over the past 36 hours he's noticed;

— Dr Murphy (@DrMurphy11) July 27, 2019

- Haemoptysis (coughing up blood)

- Pleuritic Chest pain

- Breathlessness

- A Swollen Calf

The @babylonhealth AI Chatbot Doctor, thinks he needs Antibiotics & Pain Relief. #DeathByChatbot pic.twitter.com/3MCTMqCt89

Le chatbot de Babylon aboutit après une batterie de questions à un diagnostic de pneumonie, en conseillant le “patient” de consulter un médecin. Les diagnostics les plus graves non mentionnés (même en alternative), le Dr Murphy a décidé de lancer le hashtag #DeathByChatbot (mort par chatbot).

Un problème d’algorithme ou de vision de soins?

Il est évident que si comme reporté par certains les algorithmes de diagnostic différentiel automatisé basé sur anamnèse ne mettent pas en évidence des diagnostics cliniques de haute gravité, le problème réside dans l’éducation de l’algorithme lui même, que cela puisse provenir des la qualité/quantité de données utilisées comme input ou de par la capacité de l’algorithme à “inférer” le diagnostic pendant le processus de black box. Il est aussi évident que la publicité de certaines applications ait pu également « exagérer » quant à leur capacité à poser un diagnostic indépendant.

En prenant du recul par rapport au mauvais diagnostic et au delà des implications éthiques et légales, il faut considérer qu’en attendant l’amélioration des algorithmes de diagnostic, des alternatives existent pour tout simplement faciliter la vie tant des patients que des cliniciens.

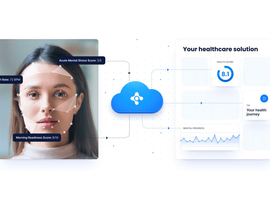

Je pense notamment à Bingli, application belge pour l’anamnèse intelligente qui permettrait aux patients d’effectuer l’anamnèse confortablement à la maison, et au clinicien d’accueillir un patient en ayant déjà pris connaissance en détail de ses plaintes. Une anamnèse aussi détaillée que celles proposées par les nouvelles applications augmentées permettrait un gain de temps d’environ 20 minutes, ou plus si nous incluons également le devoir de codage en langage informatique de type SNOMED-CT.

Dans tous les cas, la chasse aux sorcières n’est pas une façon saine d’aborder le débat de la médecine augmentée, ni d’enfin convaincre le monde médical aux bénéfices de la digitalisation.

Une safety net de médecins augmentés est nécessaire

Cet exemple ne fait que soutenir la nécessité d’un filet de sécurité tant national qu'international assuré par les médecins augmentés (médecins formés aux problématiques digitales dont l’intelligence artificielle en santé).

En apprenant les bases de fonctionnement inférentiel des algorithmes (le processus complet impossible à explorer à cause de la Black Box), les futurs experts pourront trouver l’origine des soucis dans les cas cliniques posant des problèmes à l’algorithme mais aussi aider les institutions de soins dans une amélioration permanente et qualitative des algorithmes en utilisation. Ces applications ne pourront pas s’améliorer sans un effort collectif de la part de la communauté de patients et médicale, mais l’intérêt de ces dernières doit être clair, ainsi que la vision de soins que s’y accompagne.

Dans les prochaines années, peut être suite à des soucis d’économies dans le secteur de la santé (voir la faillite de certains hôpitaux aux Pays Bas et US), les responsabilités en matière de compétences de soins pourraient se retrouver partagées entre le médecin, l’infirmier et la machine. Dans ce cas, il est nécessaire que tant les décideurs politiques tant la communauté de soignants et patients soient informées des différentes modalités de médecine 3.0, notamment en matière de supervision médicale du diagnostic.

Perspective : l’intelligence artificielle générale

Il est probable que la résolution d’un cas clinique basé sur anamnèse soit classé comme « problème complexe » ce qui expliquerait la difficulté de certaines applications à aboutir au bon diagnostic. Ceci reste un avantage en médecine clinique, et assurant au médecin qu’il gardera le contrôle sur le diagnostic encore pendant un moment.

Mais poser l’IA comme outil devient urgent sur un plan politique en matière de santé publique, d’autant plus suite à l’annonce de développement d’intelligence artificielle généralisée (ou IA forte).

Les applications augmentées sont basées à l’heure actuelle sur une IA « faible », c’est à dire une intelligence artificielle pouvant résoudre un problème précis sur base de son apprentissage.

L’IA forte peut par contre « raisonner à l’humaine » et prendre en charge les différentes complexités d’un problème plus large. Pourrons nous, par exemple, utiliser une IA forte en consultation oncologique multidisciplinaire afin d’aboutir à une indication opératoire?

Il sera dès lors important de se focaliser sur la sécurité du patient, d’où l’importance d’un cadre favorisant tant le développement que la régulation internationale des soins augmentées.

> Lire aussi :

Médecine augmentée : face au fossé politique, l’éveil scientifique (Dr Giovanni Briganti)