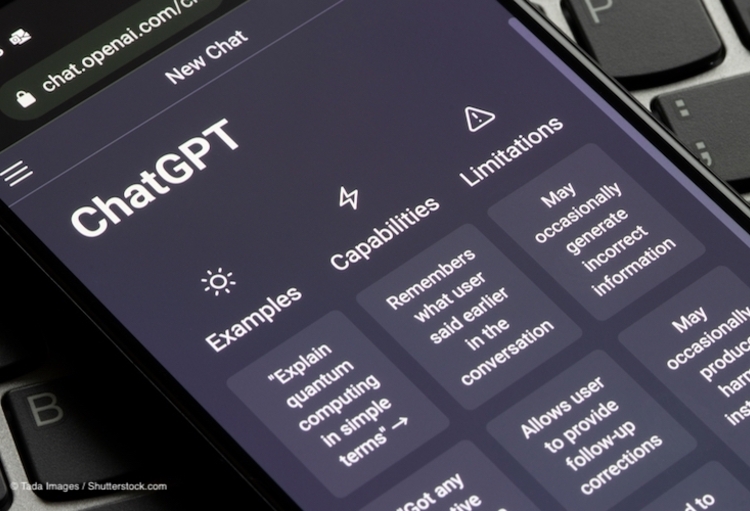

Een editorial in The Lancet gaat in op de vraag of ChatGPT een vriend of een vijand is. De intrede van ChatGPT is onvermijdelijk, maar…, zo luidt het besluit.

Niemand kan de storm rond ChatGPT (Chat Generative Pre-trained Transformer) de afgelopen maanden gemist hebben. Maar er doken ook ethische bezwaren op voor het gebruik van ChatGPT.

Auteurs Sajan B Patel en Kyle Lam, St Mary's Hospital, London, toonden de mogelijkheid van ChatGPT aan om een samenvatting van het ontslag van een patiënt te genereren op basis van een korte instructie. Door dit proces te automatiseren kunnen vertragingen bij het ontslag uit de tweede lijn worden verminderd zonder dat dit ten koste gaat van de details, waardoor artsen kostbare tijd kunnen vrijmaken voor zorg en opleiding. In een ander onderzoek werd ook de mogelijkheid getest om radiologieverslagen te vereenvoudigen, waarbij de gegenereerde verslagen over het algemeen als feitelijk correct en volledig werden beschouwd, en met een laag risico op schade voor de patiënt. Maar in beide gevallen waren er fouten. In het voorbeeld van de ontslagbrief voegde ChatGPT extra informatie aan de samenvatting toe die niet de vraag was opgenomen. Ook bij de studie van het radiologieverslag werden potentieel schadelijke fouten vastgesteld, zoals het ontbreken van belangrijke medische bevindingen. Dergelijke fouten wijzen er op dat bij toepassing in de klinische praktijk controles van de geautomatiseerde output nodig zijn.

Maar…

De beperkingen van ChatGPT zijn bekend. OpenAI geeft zelf toe dat de output van ChatGPT onjuist of bevooroordeeld kan zijn, zoals het aanhalen van niet-bestaande artikelreferenties of het bestendigen van seksistische stereotypen. Het zou ook kunnen reageren op schadelijke instructies, zoals het genereren van malware. OpenAI heeft maatregelen voorzien om de risico's te minimaliseren, maar gebruikers hebben manieren gevonden om die te omzeilen, en aangezien de output van ChatGPT kan worden gebruikt om toekomstige iteraties van het model te trainen, kunnen deze fouten worden gerecycleerd en versterkt. OpenAI heeft gebruikers gevraagd ongepaste reacties te melden om het model te helpen verbeteren, maar dit stuitte op kritiek, omdat het vaak mensen zijn die onevenredig worden getroffen door algoritmische bias (zoals mensen uit gemarginaliseerde gemeenschappen) die geacht worden te helpen bij het vinden van oplossingen.

Professor dr. Michael Liebrenz et al., Department of Forensic Psychiatry, University of Bern, 3012 Bern, Zwitserland stellen dat ChatGPT weliswaar zou kunnen dienen om het delen van kennis te democratiseren, aangezien het tekst in meerdere talen kan ontvangen en verwerken, maar dat het onnauwkeurigheden in de gegenereerde tekst de verspreiding van verkeerde informatie in de hand zouden kunnen werken.

Deze bezorgdheid heeft ernstige gevolgen voor de integriteit van wetenschappelijke gegevens, omwille van het risico op fouten en plagiaat in publicaties. Dit kan ertoe leiden dat in de toekomst besluiten over onderzoek of gezondheidsbeleid worden genomen op basis van onjuiste informatie.

Wat bewezen moet worden

De technologie evolueert en het redactiebeleid moet mee evolueren. Een wijdverbreid gebruik van ChatGPT lijkt onvermijdelijk, maar in zijn huidige vorm zou onzorgvuldig, ongecontroleerd gebruik een vijand kunnen zijn voor zowel de maatschappij als wetenschappelijke publicaties. Er moet meer worden nagedacht over en toezicht worden gehouden op de modeltraining, en er moet worden geïnvesteerd in doeltreffende AI-outputdetectoren. ChatGPT is een 'game changer', maar we zijn er nog niet klaar voor, aldus het besluit van het commentaar in The Lancet.

Laatste reacties

Marc DE MEULEMEESTER

14 april 2023Proficiat Stefaan met je heldere analyse : to the point , zo klaar als 1 glas pompwater !

Heb jij dat zelf geschreven ,?

Stefaan DENEWETH

12 april 2023"Chat GPT lijkt onvermijdelijk" Het is goed om in discussies over AI een onderscheid te maken tussen descriptieve en normatieve uitspraken. Voornoemde uitspraak is duidelijk normatief. ChatGPT is helemaal niet onvermijdelijk, het is een kwestie van wat de wetgever toelaat of niet. Zo heeft Italië als eerste land ter wereld ChatGPT verbannen. Het probleem met tools zoals ChatGPT, dat overigens inderdaad valse wetenschappelijke referenties genereert, is dat het onderscheid tussen realiteit en fictie verder vervaagt en dit ondermijnt het vertrouwen van het publiek in waarheid, wetenschap en werkelijkheid, hoewel die begrippen natuurlijk ook geen absolute feitelijkheid op zichzelf zijn. Het wordt steeds moeilijker om zelfstandig en genuanceerd na te denken. Merk op dat er recent, naar aanleiding van een zelfdoding in het kader van een gesprek met een chatbot, een open brief werd geschreven om een pauze in te lassen wat ChatGPT betreft: https://www.knack.be/nieuws/technologie/onze-samenleving-is-niet-klaar-voor-manipulatieve-ai/. Toegepast op eventuele chatbots in de Belgische gezondheidszorg: of dit meer voordelen dan nadelen oplevert, is een open vraag, maar twee belangrijke risico's bestaan erin dat patiënten enerzijds te maken krijgen met foutieve diagnoses of triages en anderzijds een te groot vertrouwen hebben in de chatbots (de zogeheten 'trust bias') en de combinatie van die twee kan gevaarlijk zijn voor de gezondheid. De vraag is wie chatbots gaat reguleren en in welke mate moeten die chatbots gereguleerd worden?

Marc DE MEULEMEESTER

12 april 2023Ik was vroeger den domsten van mijn jaar maar dank zij ChatGPT kan ik nu ook verstandige gesprekken voeren zonder op 1 barkruk te zitten , en de leugendetector zal niet vertellen dat het “ fake “ is want hij is zelf ON LINE aan den schatGPT !